Un'AI legge le onde cerebrali e le trasforma in testo

- Paolo Benanti

- 1 apr 2020

- Tempo di lettura: 4 min

Aggiornamento: 12 gen 2022

Leggere la mente ha appena fatto un passo avanti ed è pronta a divenire realtà: gli scienziati hanno sviluppato un'intelligenza artificiale che può trasformare l'attività cerebrale in testo. Alcune precisazioni e alcune precauzioni.

Mentre il sistema attualmente funziona su schemi neurali rilevati mentre qualcuno sta parlando ad alta voce, gli esperti sostengono che potrebbe eventualmente aiutare la comunicazione per i pazienti che non sono in grado di parlare o digitare, come quelli con la sindrome locked-in.

"Non siamo ancora arrivati, ma pensiamo che questa potrebbe essere la base di una protesi del linguaggio", ha affermato il dott. Joseph Makin, coautore della ricerca dell'Università della California, San Francisco.

Scrivendo sulla rivista Nature Neuroscience, Makin e colleghi rivelano come hanno sviluppato il loro sistema reclutando quattro partecipanti a cui sono stati impiantati array di elettrodi nel cervello per monitorare le crisi epilettiche.

A questi partecipanti è stato chiesto di leggere ad alta voce più di 50 frasi fisse più volte, tra cui "Tina Turner è una cantante pop" e "Quei ladri hanno rubato 30 gioielli". Il team ha monitorato la loro attività neuronale mentre stavano parlando.

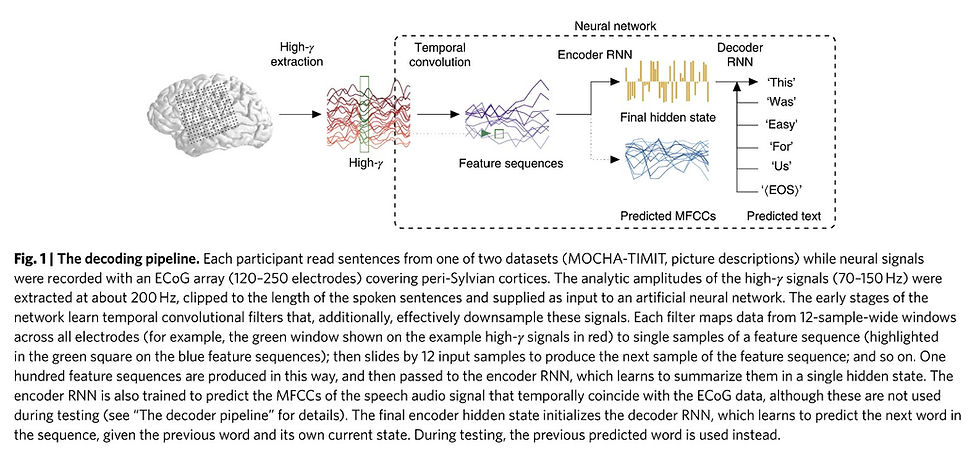

Questi dati sono stati quindi inseriti in un algoritmo di apprendimento automatico, un tipo di sistema di intelligenza artificiale che ha convertito i dati dell'attività cerebrale per ciascuna frase pronunciata in una serie di numeri.

Per assicurarsi che i numeri si riferissero solo agli aspetti del parlato, il sistema ha confrontato i suoni previsti dai piccoli frammenti dei dati dell'attività cerebrale con l'audio reale registrato. La stringa di numeri è stata quindi immessa in una seconda parte del sistema che l'ha convertita in una sequenza di parole.

Inizialmente il sistema sputava frasi senza senso. Ma quando il sistema ha confrontato ogni sequenza di parole con le frasi che sono state effettivamente lette ad alta voce, è migliorato, imparando come la stringa di numeri si relaziona alle parole e quali parole tendono a seguirsi.

Il team ha quindi testato il sistema, generando testo scritto solo dall'attività cerebrale durante il discorso.

Il sistema non era perfetto. Tra i suoi errori, "Quei musicisti si armonizzano meravigliosamente" fu decodificato come "Gli spinaci erano un cantante famoso", e "Un rotolo di filo giaceva vicino al muro" divenne "Will Robin indosserà un giglio giallo".

Tuttavia, il team ha scoperto che l'accuratezza del nuovo sistema era molto più elevata rispetto ai precedenti approcci. Mentre l'accuratezza variava da persona a persona, per un partecipante in media solo il 3% di ogni frase doveva essere corretto - un tasso di errore superiore al 5% per i trascrittori umani professionisti. Ma, il team sottolinea, a differenza di quest'ultimo, l'algoritmo gestisce solo un piccolo numero di frasi.

"Se si tenta di uscire dalle [50 frasi utilizzate] la decodifica peggiora molto", ha detto Makin, aggiungendo che il sistema si basa probabilmente su una combinazione di apprendimento di frasi particolari, identificazione di parole dall'attività cerebrale e riconoscimento di schemi generali in inglese .

Il team ha anche scoperto che l'addestramento dell'algoritmo sui dati di un partecipante significava che erano necessari meno dati di allenamento da parte dell'utente finale, cosa che potrebbe rendere l'allenamento meno oneroso per i pazienti.

Il dottor Christian Herff, esperto nel campo dell'Università di Maastricht, che non era coinvolto nello studio, ha affermato che la ricerca è stata entusiasmante perché il sistema ha utilizzato meno di 40 minuti di dati di formazione per ciascun partecipante e una raccolta limitata di frasi, anziché milioni di ore in genere necessarie.

"In questo modo raggiungono livelli di precisione che non sono stati raggiunti finora", ha detto.

Tuttavia, ha osservato che il sistema non era ancora utilizzabile per molti pazienti gravemente disabili, in quanto si basava sull'attività cerebrale registrata da persone che pronunciavano una frase ad alta voce.

"Naturalmente questa è una ricerca fantastica, ma quelle persone potrebbero anche usare ' OK Google '", ha detto. "Questa non è traduzione del pensiero [ma dell'attività del cervello coinvolta nel discorso]".

Herff sostiene che le persone non devono preoccuparsi che gli altri leggano i loro pensieri: gli elettrodi cerebrali devono essere impiantati, mentre il linguaggio immaginario è molto diverso dalla voce interiore.

Ma la dott.ssa Mahnaz Arvaneh, esperta in interfacce machine cerebrali alla Sheffield University, ha affermato che è importante considerare le questioni etiche ora. "Siamo ancora molto, molto lontani dal punto in cui le macchine potranno leggere le nostre menti", ha detto. "Ma ciò non significa che non dovremmo pensarci e non dovremmo pianificare la nostra risposta etica al riguardo."

Insomma, la domanda prima che tecnologica è etica e filosofica: nella misura in cui vogliamo affidare competenze umane, di comprensione, di giudizio e di autonomia di azione a dei sistemi software di AI dobbiamo capire il valore, in termini di conoscenza e capacità di azione, di questi sistemi che pretendono di essere intelligenti e cognitivi.

Oggi le Ai sono sviluppate o in una modalità market-driven o state-driven. Dobbiamo pensare altre modalità. Per esempio sviluppando algoritmi di verifica indipendenti che sappiano certificare queste quattro capacità delle macchine. Oppure è possibile ipotizzare enti terzi indipendenti, che attraverso la scrittura di algoritmi dedicati siano in grado di valutare l’idoneità delle AI alla convivenza con l’uomo. Solo rispettando queste indicazioni l’innovazione potrà essere guidata verso un autentico sviluppo umano.

Serve sempre di più una algor-etica che sappia guidare le innovazioni verso un autentico sviluppo.

Kart Bros IO isn’t just about reaching the finish line—it’s about being the last kart standing by outsmarting your rivals with clever tactics.